Una prótesis imaginatoria

IAs generativas: evolución, autonomía e imaginación

Llevo un tiempo interesado en la aplicación de la Inteligencia Artificial al campo de las artes desde una perspectiva práctica y teórica. Hoy los modelos avanzan, se sofistican, pero el objetivo de hiper-realismo ya se ha alcanzado; y con esto, la IA se convirtió en una herramienta a la mano y prácticamente gratis para diseñadores y el mundo del marketing.

Pero la historia es más larga y hay mucho que se quedó atrás.

En el último número que escribí en este newsletter intenté responder a esa pregunta: ¿Qué es lo que perdemos en términos creativos en el camino del realismo que ha tomado la IA generativa de imágenes? Y, ¿cómo podemos pensar y hacer uso de estas herramientas (sus modelos, sus límites, capacidades e interfaces) para la creación de arte?

En un intento de continuar con la pregunta y extender la investigación contacté a una serie de gente trabajando en esta área - el dúo artístico chileno Hypereikon y el investigador Leonardo Arriagada - para reflexionar sobre estas preguntas.

Revisa aquí las entrevistas completas

“La generación de imágenes siempre es una caja negra”, Leonardo Arriagada investigador de arte creado por IA

“Estamos explorando una imaginación artificial”, Hypereikon, dúo de artistas digitales

LA IA GENERATIVA: TÉCNICA Y EVOLUCIÓN

DeepDream de Google fue el primer experimento de la IA generativa de imágenes. El modelo basado en redes neuronales convolucionales (CNN) fue creado el 2014 con el fin de identificar objetos en imágenes. Su funcionamiento se parece al proceso cerebral que está detrás del fenómeno de la pareidolia, la ilusión por la cual vemos rostros en objetos inanimados cuando existe una combinación de ciertos elementos ordenados (como cuando vemos las nubes e interpretamos la forma de ciertas figuras en ellas, por ejemplo). Así, el modelo identifica ciertos patrones dentro de una imagen que, posteriormente, se “manifiestan” como un objeto particular.

Deep Dream marca el punto de inicio de la historia de las IAs generativas por la emergencia de esta capacidad de crear imágenes a través de procesos algorítmicos. Pero fue un inicio humilde; las imágenes están llenas de psicodelia, pero no hay figuras que parezcan reales y las imágenes que están a la base del entrenamiento de este modelo - constituida principalmente de rostros de animales - se hace presente en todas las outputs creados, prácticamente no hay transformación de los datos del input.

AUTONOMÍA CREATIVA COMPUTACIONAL

Leonardo Arriagada, PhD en Filosofía por la Universidad de Gröningen e investigador en Inteligencia Artificial y del arte generador por computadoras (CG-art) ha estudiado este tipo de imágenes hace un buen tiempo. En 2021 publicó un artículo donde desmitificó la centralidad del ser humano como creador de arte y propuso extender el estatuto de agente creativo también a las máquinas.

La clave para que esto ocurra, según Arriagada, está en que si el agente creativo es capaz o no de autoevaluar su trabajo. Cuando existe esta característica, el sistema comienza a parecerse al artista humano; como explica Arriagada, “es capaz de evaluar sus propios resultados y cambiar sus metas y estándares; ver que lo que está haciendo es una obra de arte y si no lo es, descartarlo, cambiarlo y tomar una decisión, por ejemplo lo voy a hacer más parecido a una obra de arte abstracto, impresionista, etc. Esto lo hace la IA sin intervención humana”. DeepDream como primer creador de imágenes artificiales es interesante, pero como explica Arriagada, la máquina no puede ser considerada un agente creativo porque “no posee una autonomía creativa computacional”.

Es precisamente esa característica - la autoevaluación - la que marcó la diferencia y dio paso a la segunda evolución de esta tecnología a través de las Redes Adversariales Generativas (o GAN por su sigla en inglés). El cambio en la estructura de la red neuronal (basada en una estructura doble, de ahí el nombre adversarial) permitió generar imágenes mucho más realistas y avanzar significativamente en la posible creación de arte.

El ejemplo más notorio fue la subasta en Christie’s por más de 400k dólares de la obra Retrato de Edmond Belamy en 2018. Pero lo más importante aquí es que la máquina firma, esto es, es considerado un artista más dentro de la obra. Aquí la máquina expresa esa autonomía creativa computacional a través de un lienzo y, su trabajo es reconocido como hecho por un artista. “En este caso tú no estás pensando que la IA será mejor representando, porque no estamos en presencia de una nueva herramienta que hace mejor lo que hace un ser humano, sino una máquina que muchos artistas, filósofos e informáticos consideran un nuevo partner, con agencia creativa propia” - comenta Arriagada.

HACIA UNA IMAGINACIÓN ARTIFICIAL

A pesar del avance técnico que significó el arte creado por GAN, aún así, el modelo no llegó a popularizarse porque fue capaz de crear imágenes lo suficientemente realistas y, en segundo lugar, se necesitaba conocimiento técnico para hacer uso de esta herramienta.

En la tercera etapa de la evolución de las IAs generativas, todo esto cambió cuando aparecieron los modelos de difusión (DM, por su sigla en inglés), que están detrás de las herramientas más comunes como Stability.IA, Dall-e o Midjourney. Su masificación también implicó que nuevos públicos comenzaron a ver la utilidad de estas herramientas, como por ejemplo la publicidad y el marketing. Estos modelos son capaces de lograr imágenes hiper-realistas en pocos pasos y de forma rápida y barata.

Pero aquí estas herramientas rápidamente pierden su carácter estético-artístico. Principalmente porque estos modelos no están construidos con el principio de autonomía creativa computacional; la máquina ejecuta el prompt solicitado, pero ya no piensa por sí misma ni experimenta. Lo que se espera de ella son resultados correctos, no experimentación.

Hypereikon es el nombre de un dúo de artistas electrónicos chilenos radicados en Buenos Aires. Constanza Lobos y Sebastián Rojas son originarios de Valdivia y desde hace un tiempo que trabajan con herramientas de IA con fines experimentales. Esto es, jugar y torcer los motores de IAs generativas para escapar a la representación de conceptos e imágenes obvias. “Estos modelos a nivel de arquitectura permiten el movimiento entre distintos imagemas o combinación de imaginarios, pero están optimizados o tienen un sesgo hacia lo hermoso”, comentan.

Lo que los modelos de difusión nos han entregado han sido resultados inteligibles y bellos, gracias a una arquitectura optimizada para alcanzar esos objetivos. En primer lugar, cumplen con nuestras expectativas codificadas a través del lenguaje y en segundo lugar, son herramientas ya previamente determinadas en sus objetivos: alcanzar lo familiar y lo representativo, a continuar en línea con los datos con los cuales fueron entrenados.

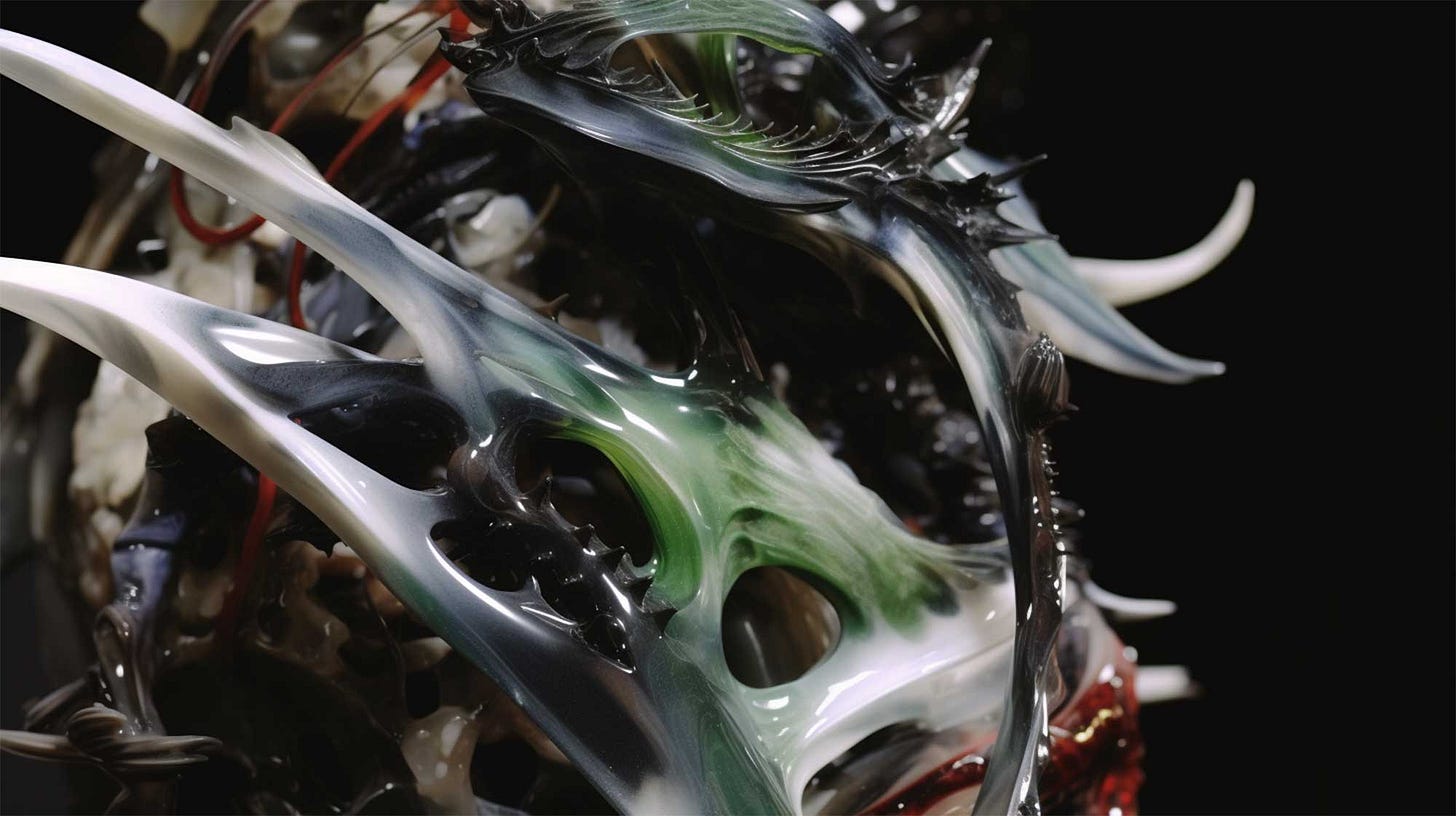

La obra de Hypereikon toma como punto de partida de inspiración la naturaleza; una naturaleza que está intervenida por el humano, en donde se producen procesos de simbiosis entre distintas inteligencias, seres vivos e inorgánicos. Aquí la naturaleza no es la imagen de un bosque, sino “una sopa primordial de conceptos. Esto también viene de nuestra inspiración en la realidad valdiviana donde existe esa simbiosis. No vivimos en una naturaleza prístina, vivimos en una contaminada”, explican.

Este híbrido entre algo técnico, mecánico o tecnológico mezclado con lo natural se manifiesta en las imágenes que crean: flores que no existen, texturas etéreas o especies de animales o insectos extraterrestres que mezclan distintos elementos dentro de sus figuras.

Para alcanzar estos resultados usando herramientas tradicionales como MidJourney o Stable Diffusion, el dúo no utiliza el lenguaje, sino que parten de otras fotografías (en particular imágenes que representan la naturaleza valdiviana por ejemplo), trabajos que ya han hecho en el pasado o texto incoherente que tuerce los usos tradicionales de estos modelos e impulsa a la máquina a escapar de sus curvas estadísticas, bordeando el límite de la representación.

La idea es “ver una imagen y preguntarse qué es esto, qué me hace ver, qué referencias están mezcladas en esta imagen” - comentan al describir su proceso - “hay mucho espacio creativo y artístico para explorar en ese desenredar las nubes de posibilidades. Con la práctica y el tiempo uno comienza a ver los patrones, la forma en que coagulan formas, figuras o composiciones. Es un juego, un proceso de feedback infinito en que uno está elongando o ejercitando esa imaginación constantemente”, agregan.

Aquí la tecnología se convierte en un vector para explorar eso que aún no podemos poner en palabras - nuestra relación híbrida con una naturaleza que está intervenida y que se manifiesta de distintas formas - y la máquina se convierte en una herramienta para explorar ese espacio latente de elementos, aún fuera de nuestros conceptos. Aquí la herramienta es utilizada para extender la imaginación, no constreñirla al reino de lo familiar. “Nos planteamos que estamos explorando una imaginación artificial. Un creador de imágenes, más que una inteligencia como un ente autónomo con agencia propia, que es lo que se promueve”, comentan.